HBM, la memoria VRAM que solo se ve en centros de datos

Ha pasado por varias versiones, HBM, HBM2, HBM2E, HBM3 y HBM4 que debutará en 2026 si todo va bien. HBM (High Bandwidth Memory) es un tipo de chip de memoria caracterizado por el apilamiento 3D de las DRAM que son interconectadas por un interposer (TSV) y que logra un bajo consumo junto con un ancho de banda enorme.

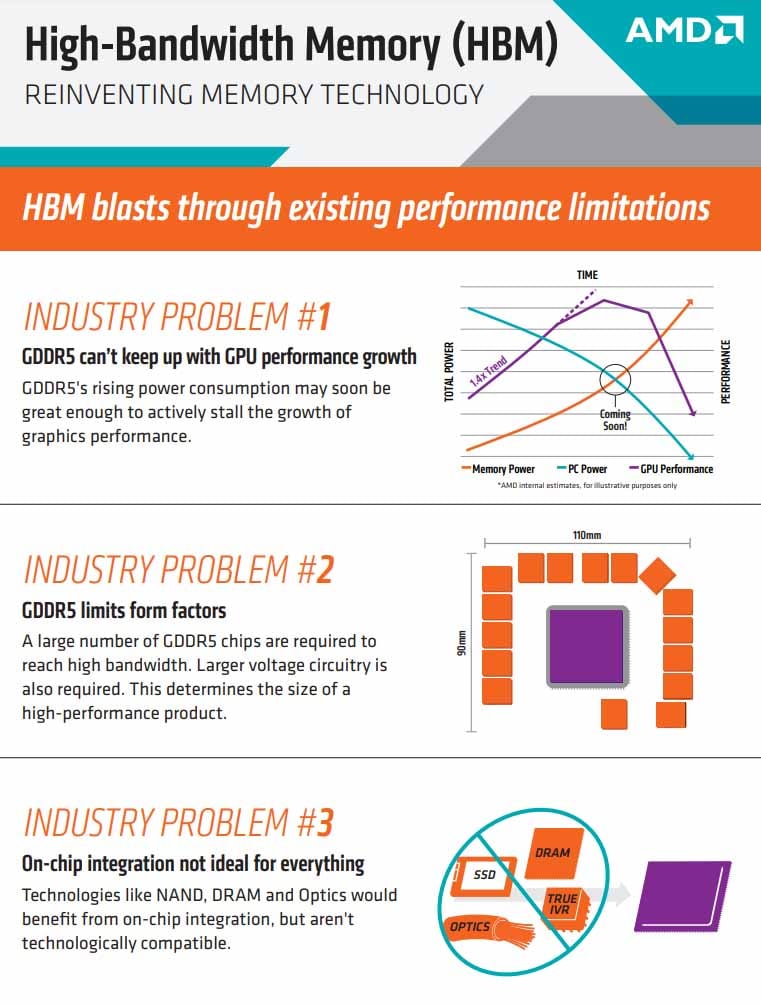

AMD ya planteó este enfoque en tarjetas gráficas porque se dieron cuenta de 3 problemas:

- GDDR5 no podía mantener el crecimiento del rendimiento en GPU.

- La instalación de los chips de memoria GDDR provocaba factores de forma limitados, debiendo “morir” al diseño de rodear la GPU con memorias de 1 o 2 GB.

- Que la integración del chip no fuese ideal.

Los beneficios de HBM eran claros:

- Mejor ancho de banda por vatio.

- Un bus de memoria mucho más grande (1024-bit).

- Una frecuencia más baja.

- Un ancho de banda gigantesco en comparación con GDDR.

- Menos voltaje.

- 94% menos de uso de la PCB para la misma capacidad.

¿Cuál es la única desventaja? El coste de fabricación e implementación en la PCB de la tarjeta gráfica. Tanto fabricarla, como instalarla, es mucho más costoso que cualquier memoria GDDR.

Entonces, si tenemos una tecnología de chip que doblega prácticamente a GDDR en todo, ¿por qué no está en AMD Radeon y NVIDIA GeForce?

Lo cierto es que sí lo estuvo. Nos remontamos a 2015 y a la AMD Radeon R9 Fury X: la primera GPU en implementar HBM fabricada por SK hynix que costaba unos 700€ de salida. Actualmente hay un 20% de inflación respecto a 2015, así que estamos hablando de un equivalente a 840€ actuales. ¡Qué barbaridad!

Hablando de datos macroeconómicos, el PIB per cápita de España en 2015 era unos 23.230€, mientras que en 2022 fue de 28.280€.

Esta tarjeta gráfica competía con la NVIDIA GTX 980 Ti, que traía casi 3000 CUDA Cores y cuyo precio era muy similar: unos 800 u 850 euros. Ahora bien, la GPU AMD venía con HBM y la GTX 980 Ti con GDDR5: por lógica debería ganar la AMD solventemente, ¿no?

No fue así, de hecho, la GTX 980 “a secas” ya le ganaba en muchos juegos. Es decir, fue un fracaso porque debería haber vapuleado a NVIDIA, pero no fue así.

Sin embargo, AMD no se rindió y quiso probar de nuevo con HBM2 en 2017 con Vega. Os dejo algunas especificaciones de las GPUs que salieron con HBM2:

- Radeon RX Vega 56 (8 GB HBM2 con un bus de 2048-bit y un ancho de banda de 409.6 GB/s).

- Radeon RX Vega 64 (8 GB HBM2 con un bus de 2048-bit y un ancho de banda de 483.8 GB/s).

De nuevo, no fueron competencia para la GTX 1070 y 1080, además de consumir mucha energía y de tener temperaturas polémicas (el modelo de AMD venía con turbina).

El último intento de la marca sería la Radeon VII en 2019, que traía 16 GB HBM2, bus de 4096-bit y 1 TB/s. La cifra de banda ancha de 1 TB/s recorrió el mundo y tuvo mucho marketing, pero lo cierto es que no venció a las RTX 2080 que salieron en 2018.

Tras estos 3 tropiezos seguidos en gama alta de AMD (en gama media lanzaron muy buenas GPUs), llegó RDNA con las RX 5700 XT que funcionaron y se vendieron maravillosamente.

GDDR, lo que sigue funcionando en las tarjetas gráficas de consumo

Ya va cogiendo color este GDDR vs HBM, y es que GDDR, GDDR2, GDDR3, GDDR4, GDDR5, GDDR5X, GDDR6, GDDR6X y ahora GDDR7 se han llevado el gato al agua en consumo.

Con los números en la mano, AMD y NVIDIA ganan más dinero en GPUs para centros de datos que en las gamas Radeon o GeForce. Además, si le sumamos que ahora hay una “locura por la IA” y se están vendiendo las tarjetas gráficas como churros en los datacenters… apaga y vámonos.

| Ingresos por segmentos Q2 2025 | |||

| Q2 2025 | Q1 2025 | Q2 2022 | |

| Centros de datos | $10,323M | $4,284M | $3,806M |

| Gaming | $2,486M | $2,240M | $2,042M |

| Visualización profesional | $379M | $295M | $496M |

| Automoción | $253M | $296M | $220M |

| OEM & IP | $66M | $77M | $140M |

Eso sí, lo que se vende en centros de datos sí que tiene memoria HBM3 o más reciente porque cuando hablamos de datos lo que interesa es el ancho de banda. Y eso te lo da HBM frente a GDDR.

¿Qué podemos decir de GDDR? GDDR es memoria gráfica de doble velocidad de datos (Graphics Double Data Rate) que está especializada en la renderización de modelos o texturas. Los pilares de esta tecnología se remontan al año 2000, pero en 2025 llega GDDR7: 7 versiones en 24 años.

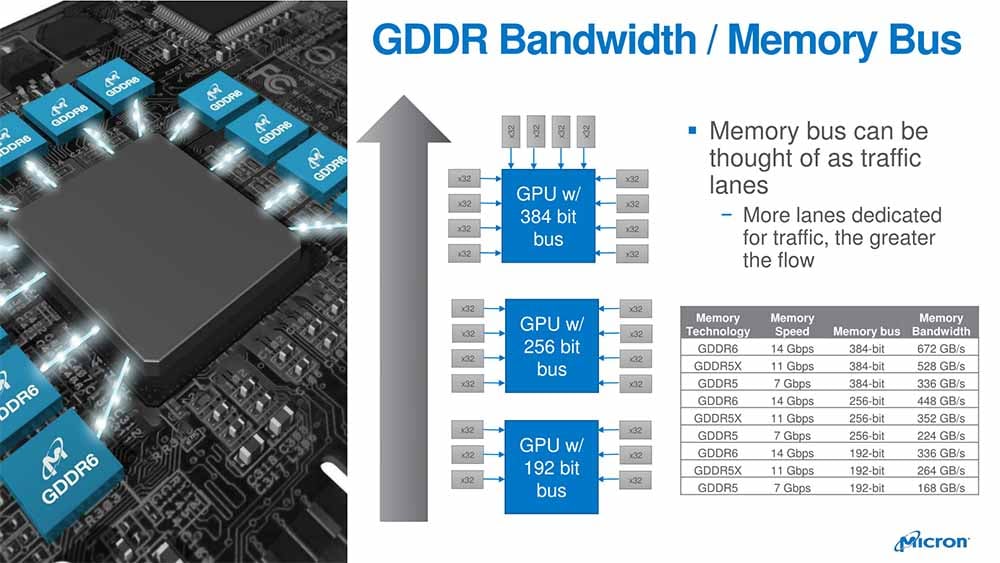

Su factor de forma es sencillo: se instalan módulos de memoria GDDR alrededor de la GPU para evitar la menor latencia a la hora de realizar operaciones. Ya sabéis, cuando los datos viajen lo menos posible de la GPU o hacia la GPU… mejor.

Normalmente, cada chip de memoria tiene 1 o 2 GB, por lo que se debe instalar varios en cada GPU para obtener 6, 8, 12, 16, 20 o 24 GB. Su coste de fabricación es contenido e instalarlas en una PCB tampoco es complicado con la tecnología actual.

Destacar que en cada módulo GDDR se instala encima una thermal pad para la expulsión del calor hacia el disipador de la GPU. Fijaros al abrir vuestra GPU y desmontar su disipador